proxmox ve结合ceph,组建高可用虚拟化平台,故障自动迁移

Proxmox创建集群组ceph需要至少三个节点,本次实验为三台服务器,每台服务器系统为proxmox6.4,数据盘为各三块2.4t机械盘Exmo。

一、更换系统源

为每台服务器安装好系统后,首先都需要更新update和upgrade,自带的更新源速度很慢,所以需要改成中文源Exmo。

1.更换阿里源

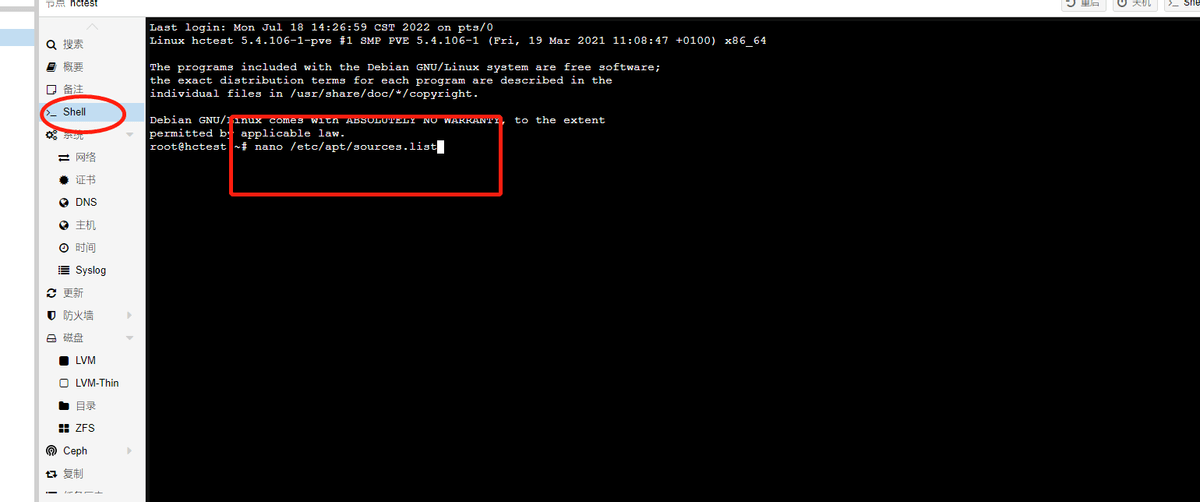

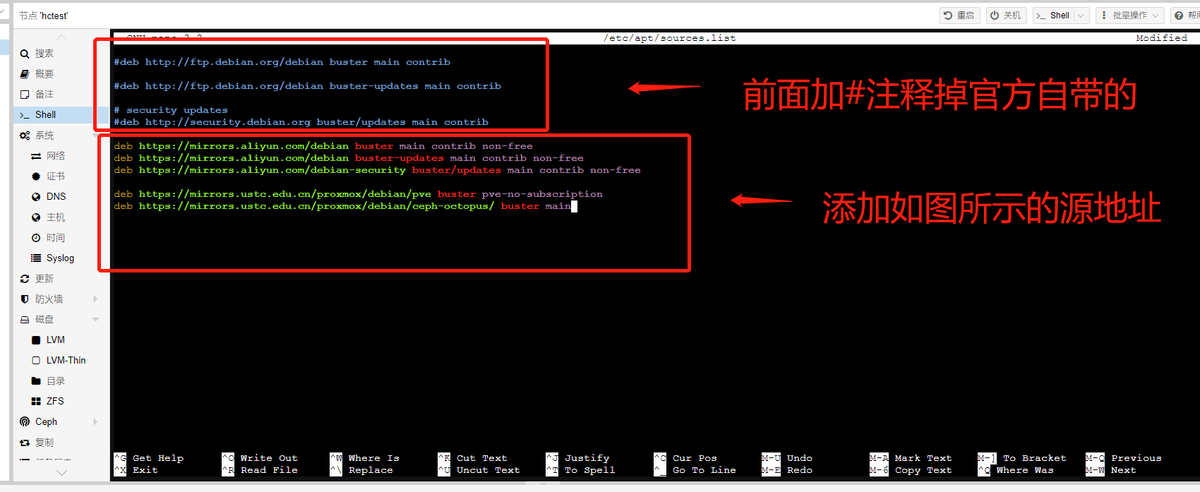

Shell命令行下输入nano /etc/apt/sources.list

进入编辑界面

源地址如下:

deb

deb

展开全文

deb

deb

deb

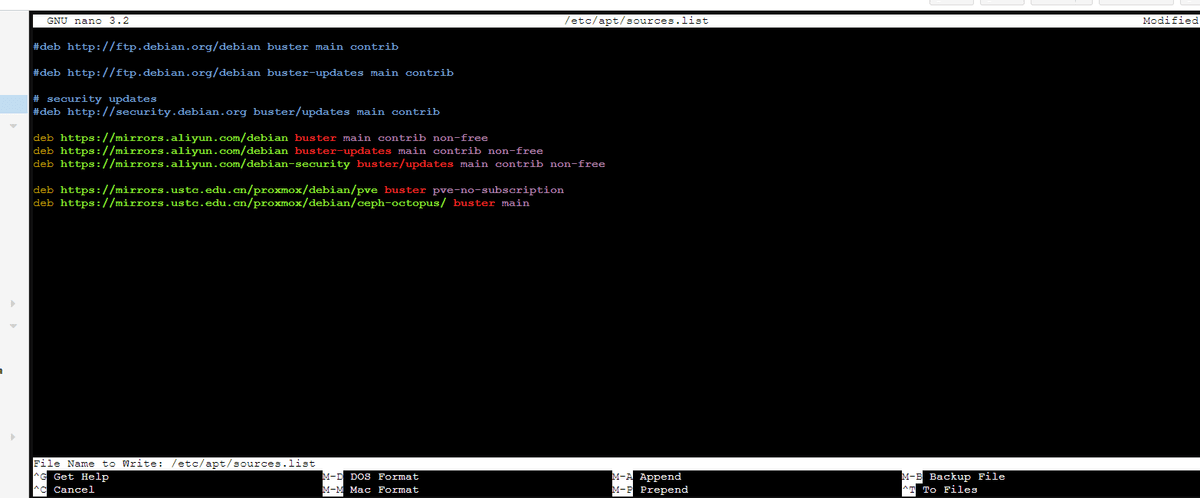

然后按ctrl+o保存修改:

然后如上图所示,点击回车键Exmo。然后按ctrl+x退出编辑界面。

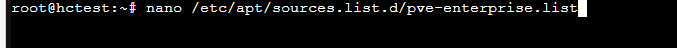

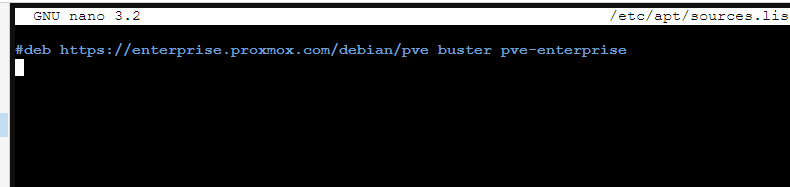

2.去除企业源Exmo,方法同理:

输入nano /etc/apt/sources.list.d/pve-enterprise.list

注释掉企业源,ctrl+o保存,然后回车,最后ctrl+x退出Exmo。

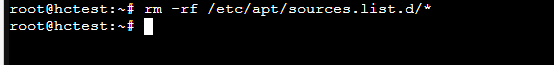

3. 删除该目录下所有文件Exmo。

输入rm -rf /etc/apt/sources.list.d/* (注意目录别删除Exmo了)

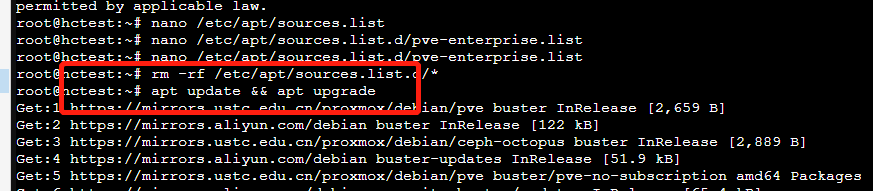

4.更新update和upgrade

输入apt update && apt upgradeExmo,更新源和包

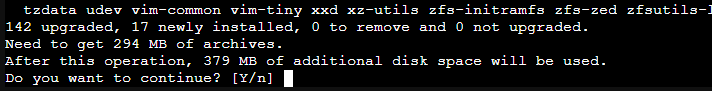

如下提示输入yExmo,等待安装完成

二、建立集群

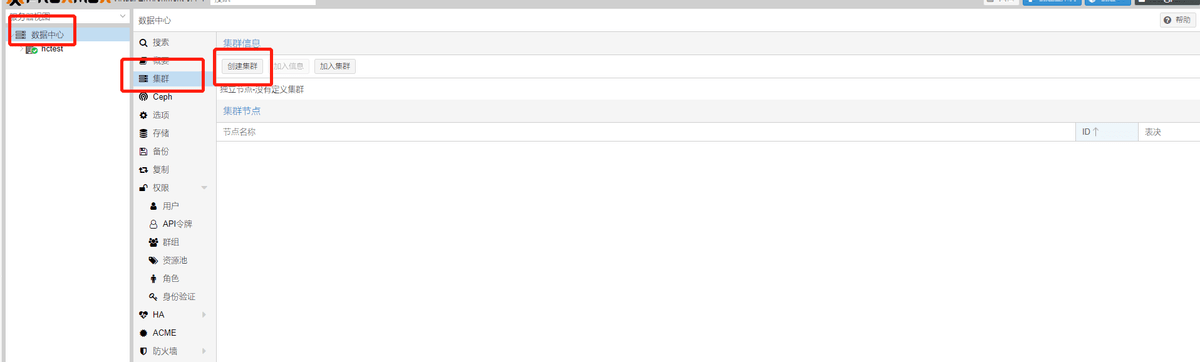

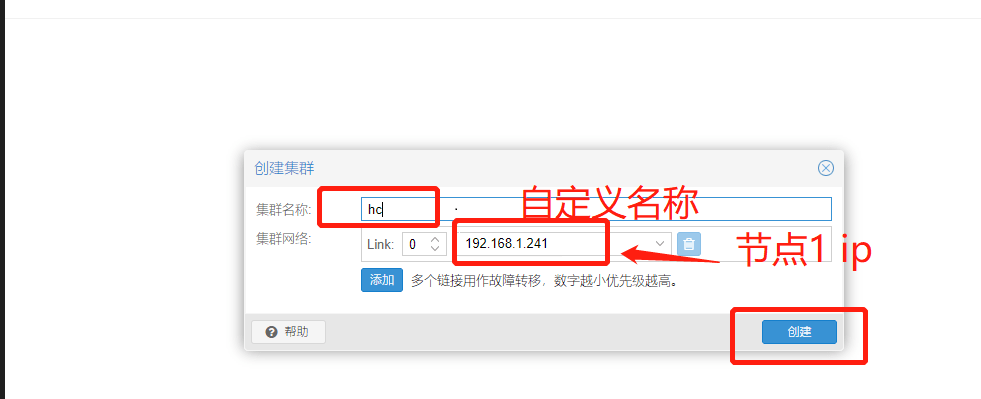

1.建立集群

安装成功之后Exmo,首先需要建立集群,首先用节点1创建集群:

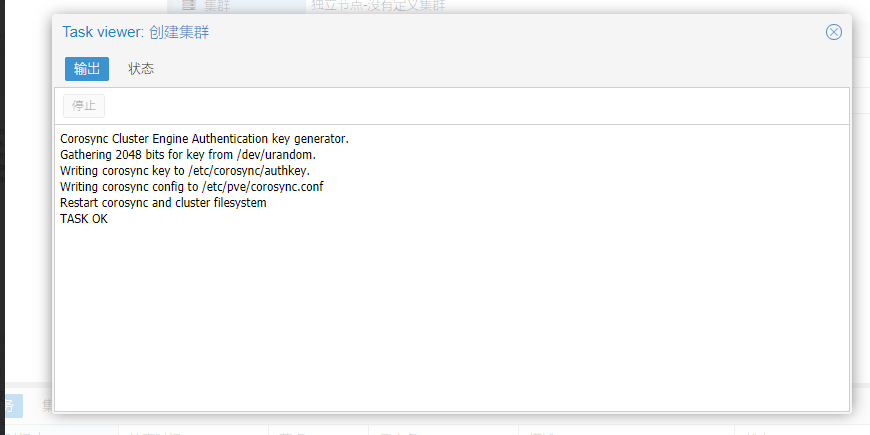

提示创建成功Exmo。

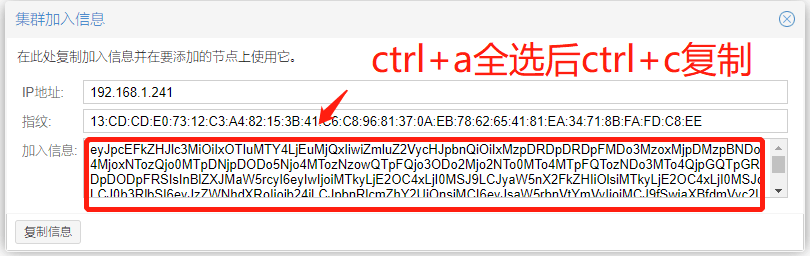

然后查看加入信息

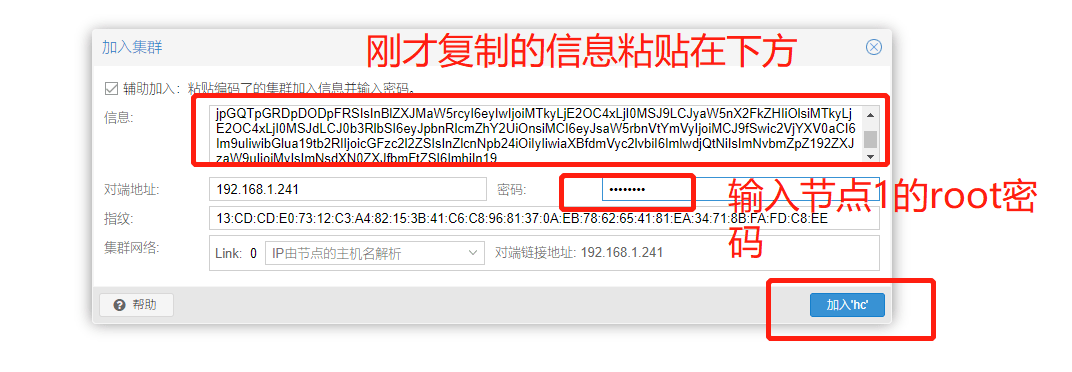

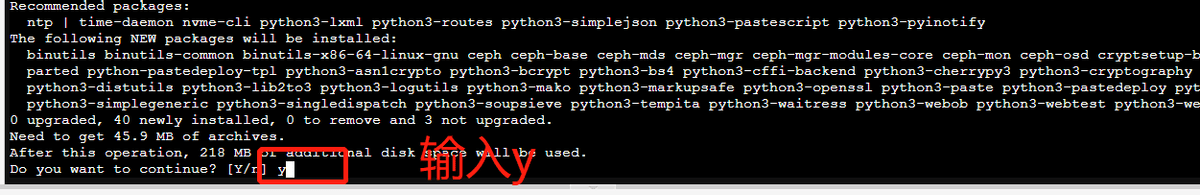

2.加入集群

将节点2和3分别加入节点1创建的集群Exmo。

成功加入集群Exmo。

三、安装配置ceph

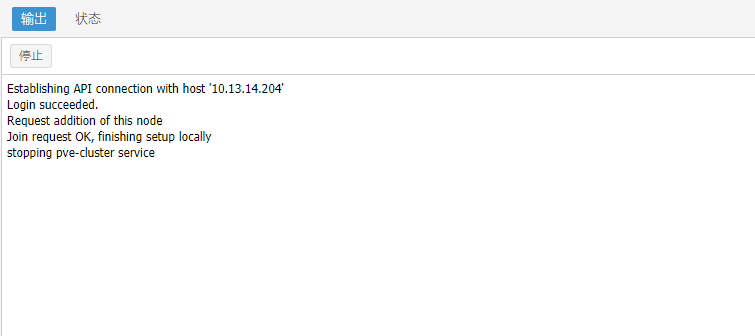

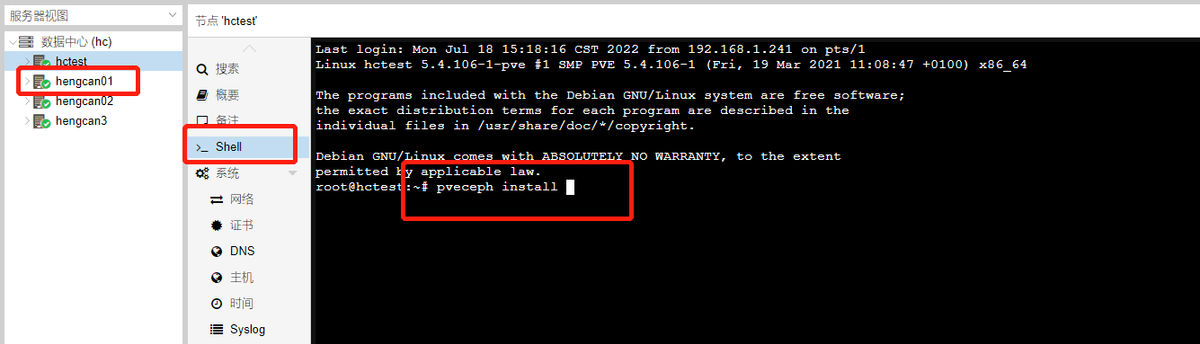

1.为每个节点安装ceph

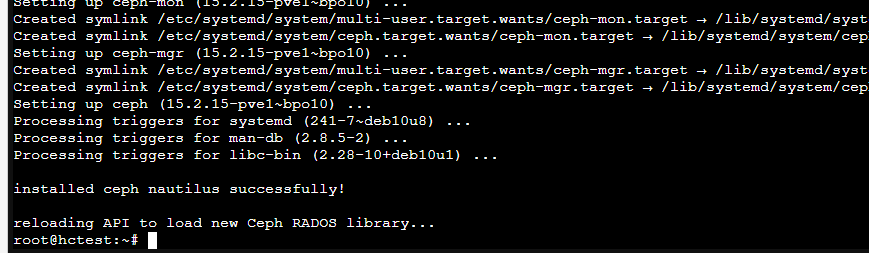

每个节点进入命令行,然后后执行pveceph install 就可以了Exmo。

最后提示成功即可

2.为每个节点添加osd磁盘

命令行输入 fdisk -lExmo,查看所有盘符,

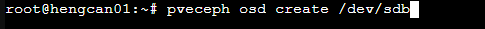

pveceph osd create /dev/sd[X]------X对应的盘符

例如pveceph osd create /dev/sdb为将sdb挂载成osd盘Exmo。

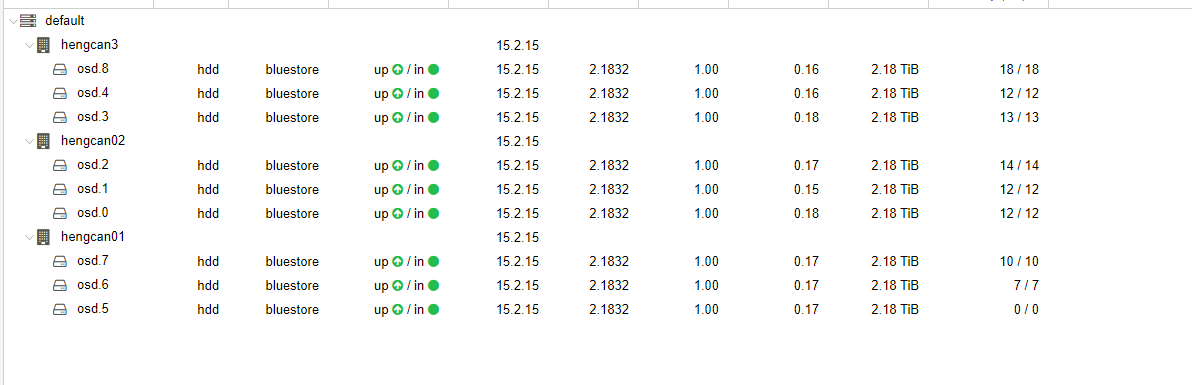

将各个节点osd盘创建好Exmo。

如果提示报错Exmo,说明磁盘在使用,

需要输入如下命令

ceph-volume lvm zap /dev/sd[X]-----X对应的盘符

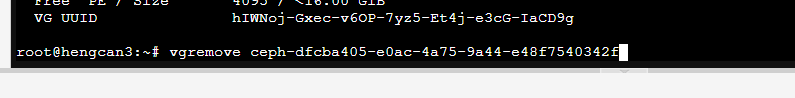

如果还是报错Exmo,需要

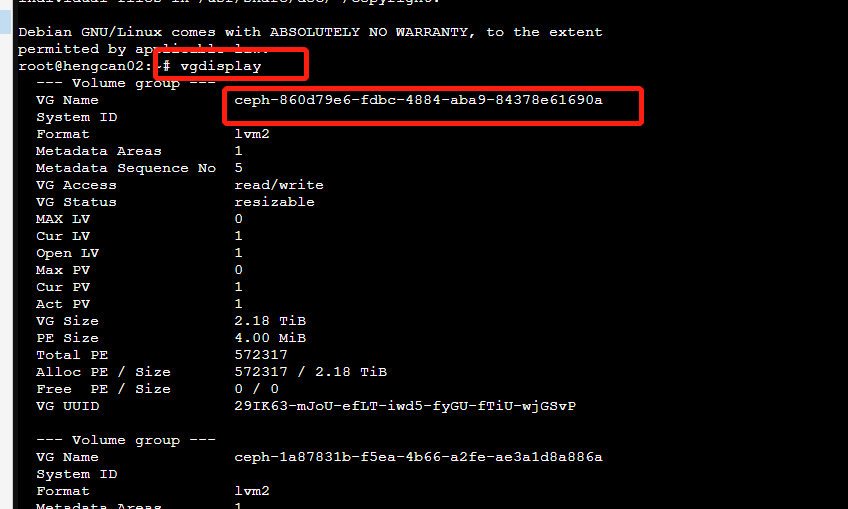

先vgdisplay Exmo,查看所有vg卷组,把非系统卷组全部移除,

命令如下

用vgremove移除对应的卷组

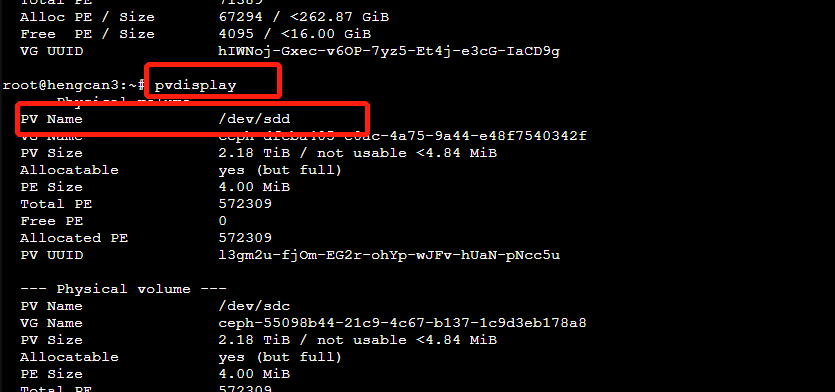

同理移除全部需要移除的vg后Exmo,需要pvdisplay查看所有被占用的物理卷

同样pvremove移除对应的物理卷

移除之后,reboot重启节点Exmo。

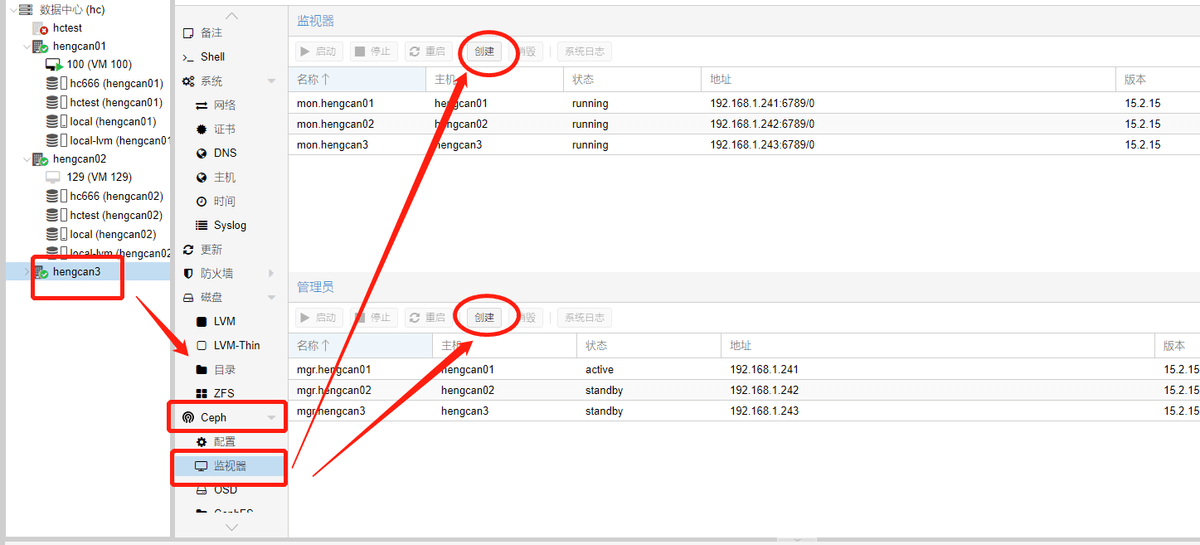

3.分别把对应监控节点和管理节点添加进节点1,2,3Exmo。

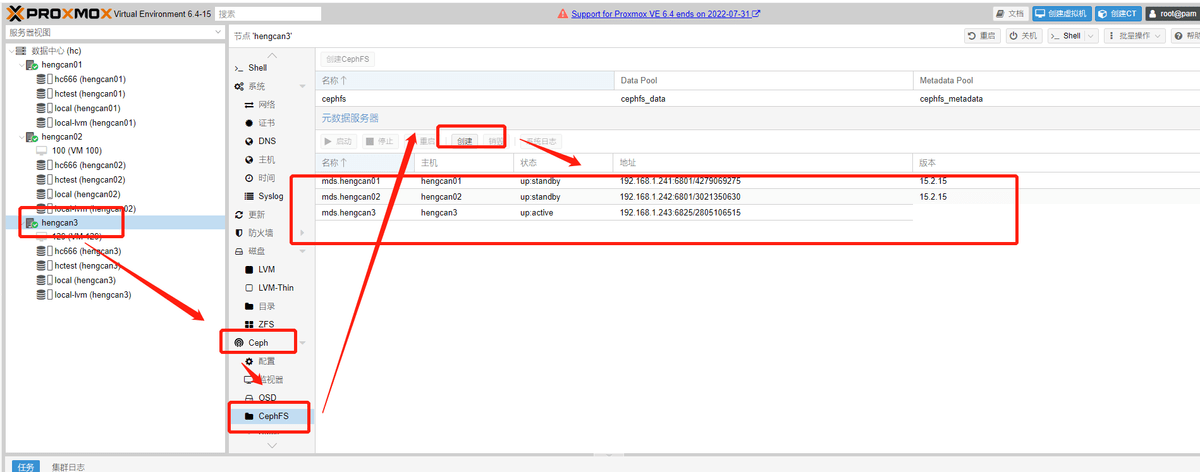

4.将cephfs组元加入各个节点

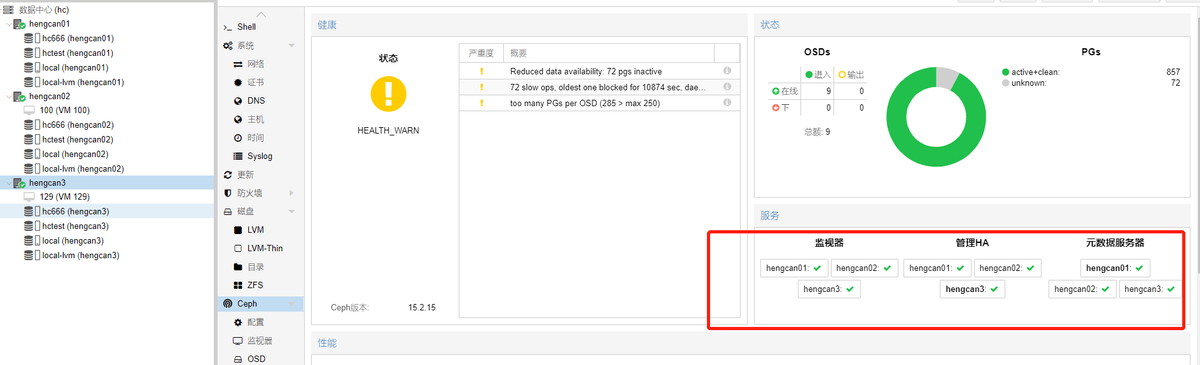

执行以上步骤后Exmo,最后如下图为配置成功

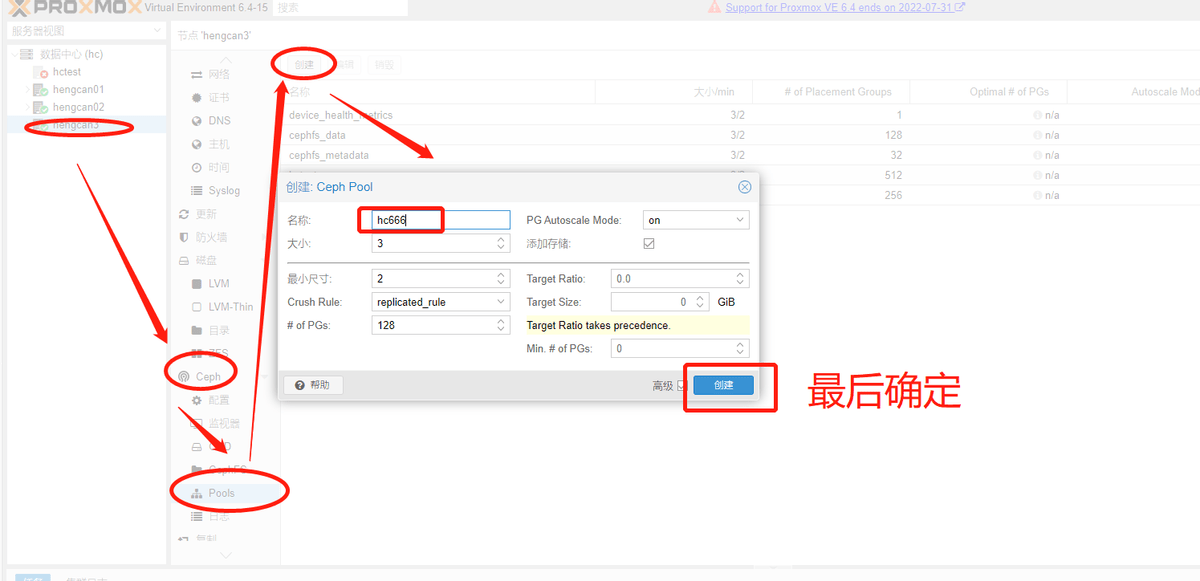

5.创建ceph pool池

根据官方的文档Exmo,of_PGs这个数值比较关键,如果不合适的话,Ceph会告警,官方建议:

若少于5个OSD, 设置pg_num为128Exmo。

5~10个OSD,设置pg_num为512Exmo。

10~50个OSD,设置pg_num为4096Exmo。

创建好后每个节点都会出现创建的pool池Exmo。

四、迁移测试

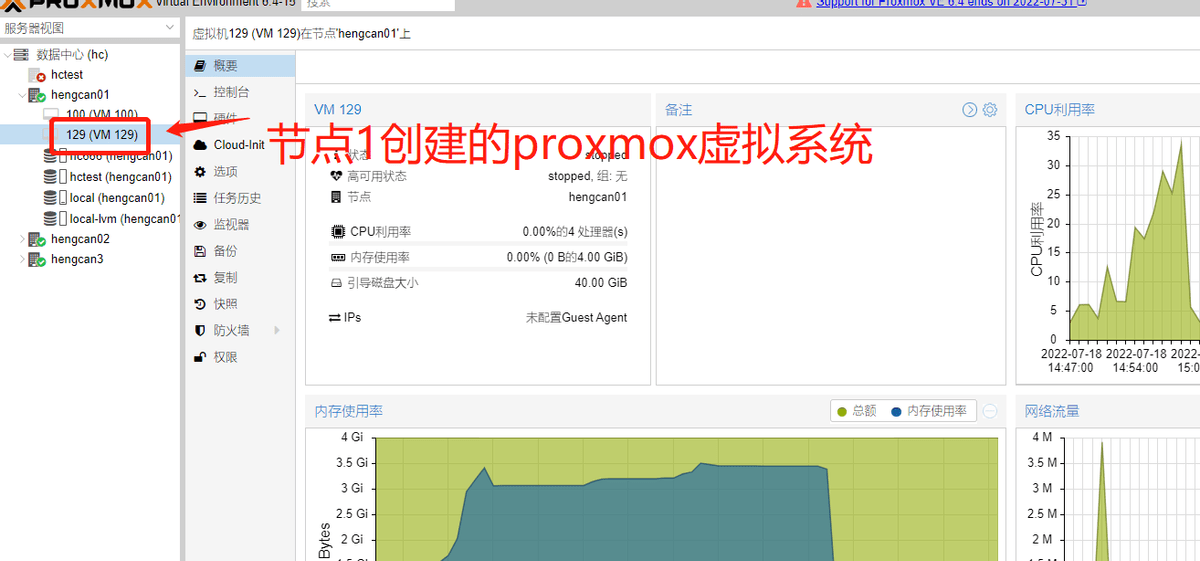

最后可以进行迁移测试了,在任意节点上安装个虚拟系统,本次实验为节点1安装编号为129的系统为proxmox的虚拟机Exmo。

如图节点1安装一个proxmox系统

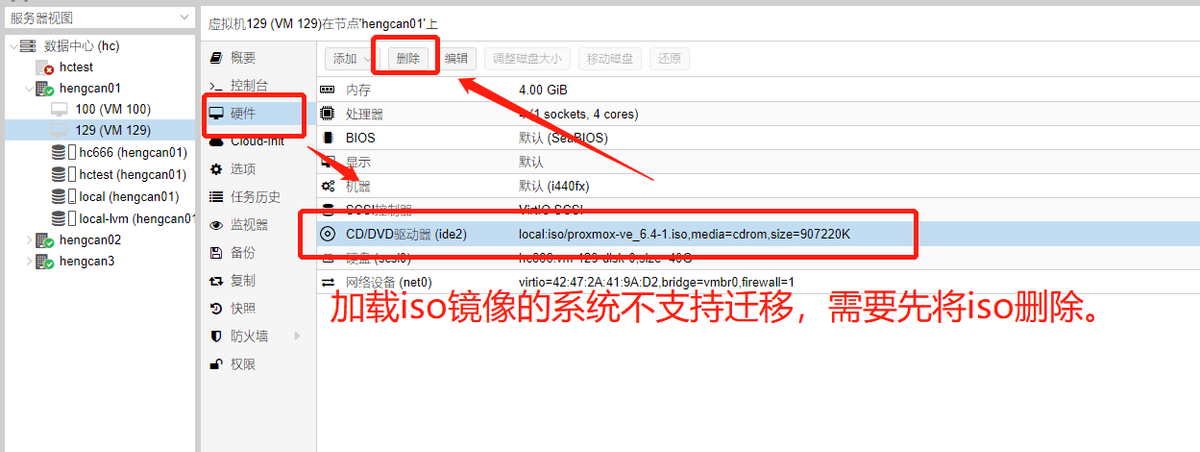

如图需要先将虚拟机的iso删除,否则不会迁移Exmo。会提示报错

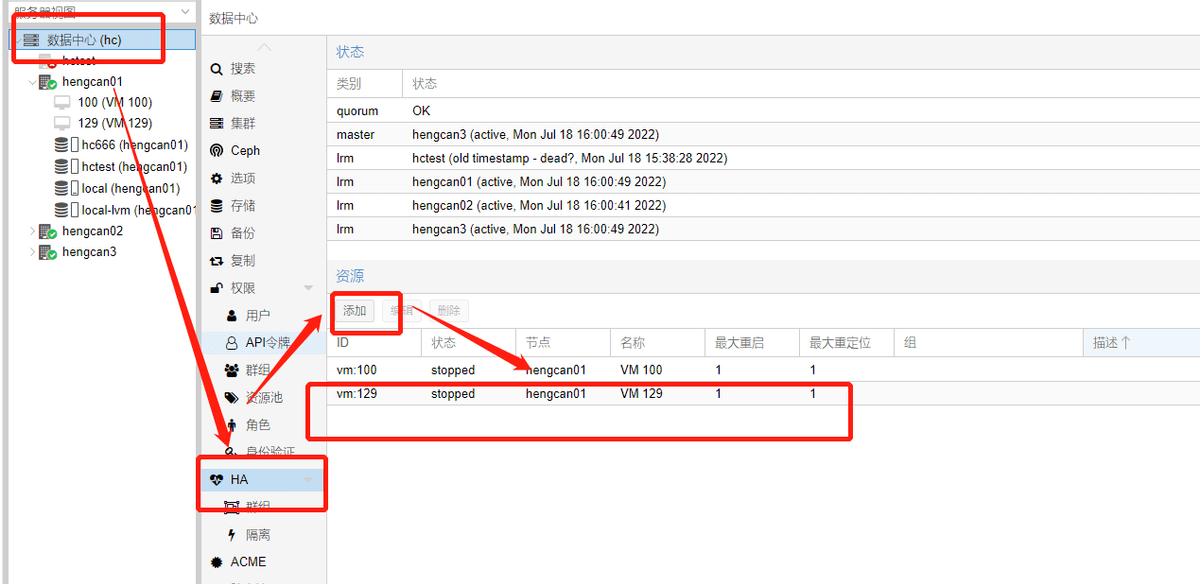

将刚才创建的虚拟机添加进HA中Exmo。

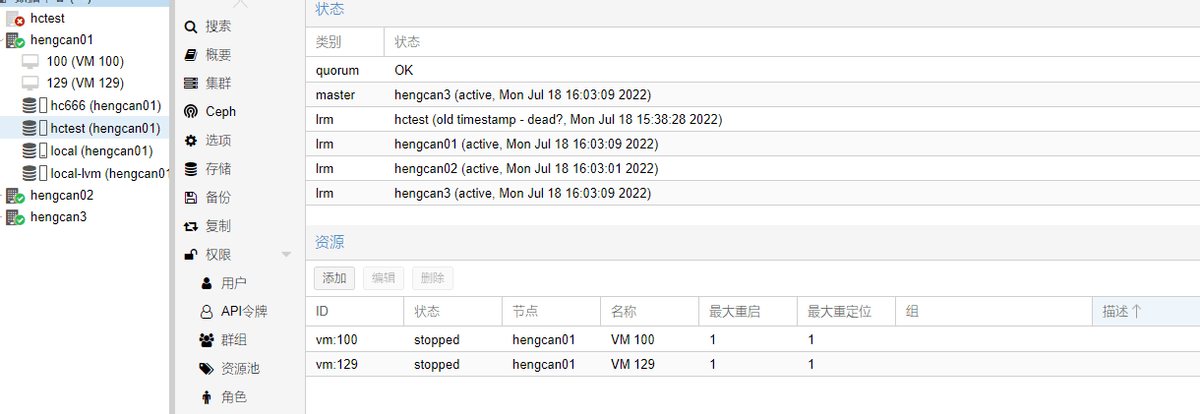

此时节点3为master状态Exmo,节点1,2,3都是激活状态

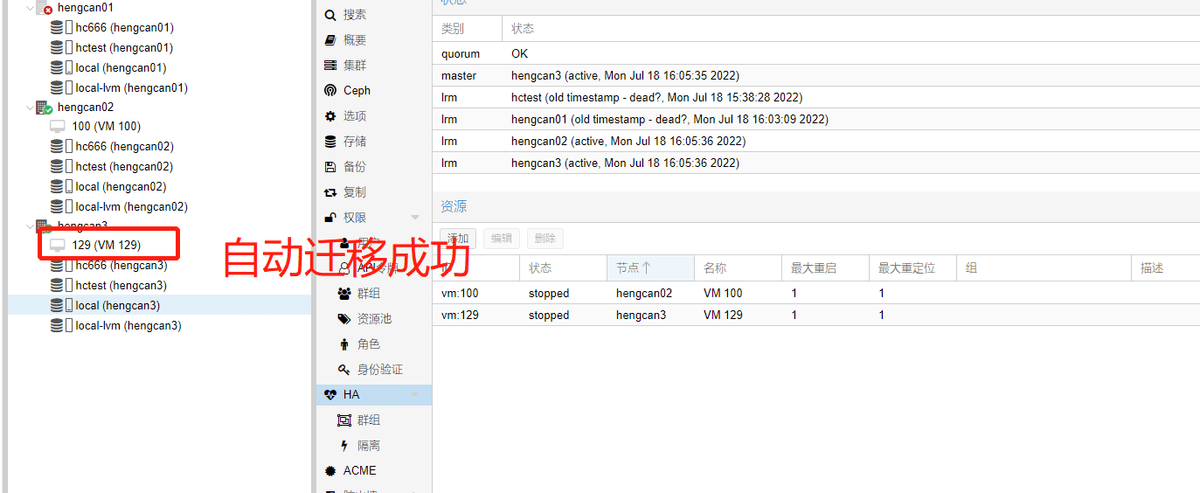

关闭节点1Exmo,hengcan01 等待片刻

此时节点1是断开状态,节点2,3为活动状态Exmo。至此,实验成功。

评论